「奔向 AGI」栏目聚焦 AI 大模型、AI agent、AI 应用、芯片、机器人等前沿、热门的 AI 技术和商业创新。

「奔向 AGI」栏目聚焦 AI 大模型、AI agent、AI 应用、芯片、机器人等前沿、热门的 AI 技术和商业创新。

又一位华人女性即将在美国科技领域书写新传奇。

据科技媒体 The Information 消息,人工智能云服务初创公司 Fireworks AI,正计划启动新一轮融资,目标估值达 40 亿美元(约合 288 亿元人民币,该估值已包含本轮融资金额)。

目前,知名风投机构 Lightspeed Venture Partners(美国光速 )与 Index Ventures 等正就领投事宜展开深入磋商。

若此次融资顺利达成,Fireworks AI 的估值将在短短一年内实现超 7 倍的飞跃。这也再次凸显了投资机构对 AI 基础设施领域,特别是推理服务赛道的浓厚兴趣。

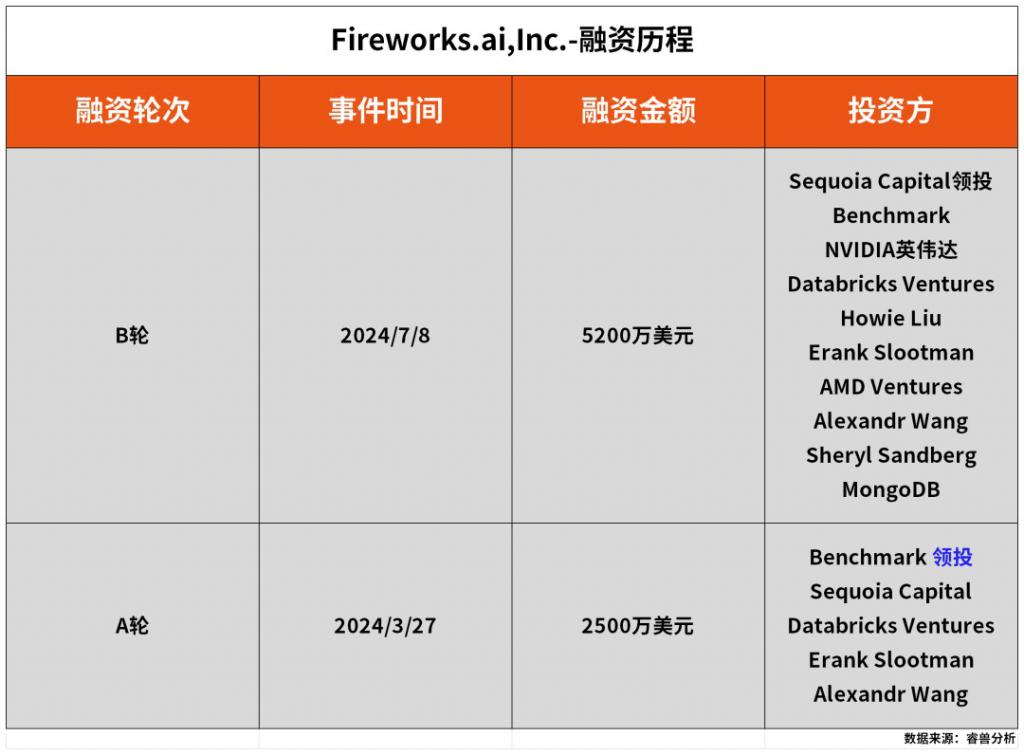

值得一提的是,这家公司已获得多家顶级投资机构的青睐。此前,红杉资本、Benchmark 等硅谷老牌风投,以及英伟达、AMD、Databricks Ventures 和 MongoDB Ventures 等产业资本均已参与其早期融资。

复旦才女创业

帮企业低成本、高效定制开源大模型

这位复旦计算机系校友正悄然改写 AI 基础设施的竞争规则。

乔琳(Lin Qiao)在复旦大学计算机本硕连读毕业后,便远赴加州大学圣巴巴拉分校(UC Santa Barbara)攻读计算机博士学位。

她的职业生涯始于 IBM 担任研究职位,专注于数据基础设施和数据库技术,随后在 LinkedIn 担任技术主管,最终在 Meta(原 Facebook)担任 AI 平台架构关键负责人,曾领导超过 300 人的工程师团队,主导全球 PyTorch 框架的基础设施研发及大规模部署。

此后,她带领团队成功推动 PyTorch 成为行业标杆的开源框架,并将其部署至 Meta 的全球数据中心、移动设备和 AR/VR 平台。

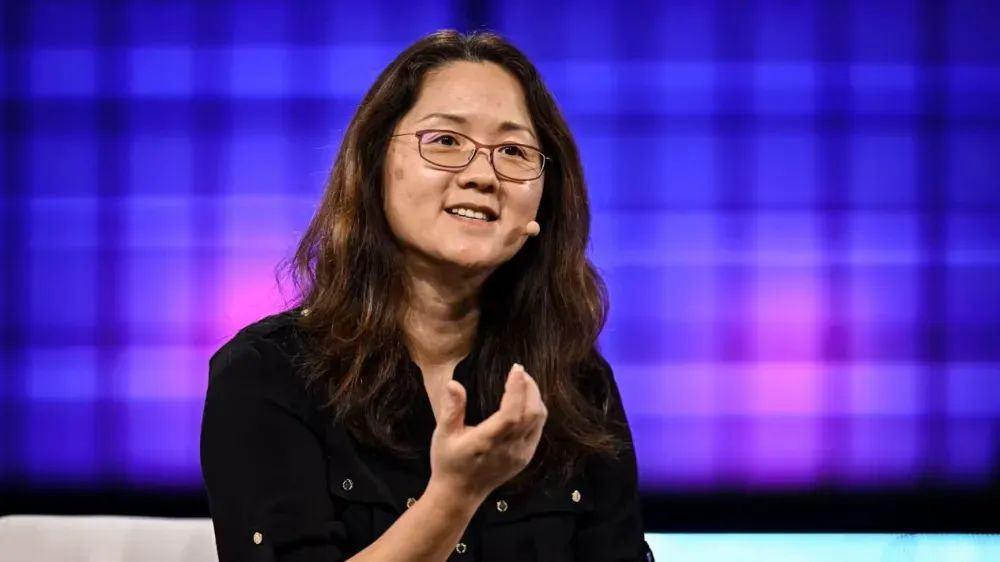

Fireworks AI 联合创始人兼首席执行官乔琳(Lin Qiao),图源:The Information

Fireworks AI 联合创始人兼首席执行官乔琳(Lin Qiao),图源:The Information

这段在科技巨头打磨的经历,为乔琳积累了深厚的 AI 底层架构研发经验。

作为全球主流开源机器学习框架 PyTorch 的关键建设者,她带领团队攻克的技术难题,如今正转化为 Fireworks AI 的核心竞争力。

当年在 Meta,乔琳见证了一个重要规律:PyTorch 之所以能在数十个同类框架竞争中胜出,关键在于 " 把复杂留给团队,把简单带给用户 " 的设计哲学。

尽管背后是数百名工程师构建的复杂技术体系,但开发者只需简单调用即可获得强大功能——这种用户体验至上的理念,成为她创立 Fireworks AI 的初心。

" 真正的创新不在于功能堆砌,而在于让技术回归本质。" 乔琳将这种思考注入创业实践。

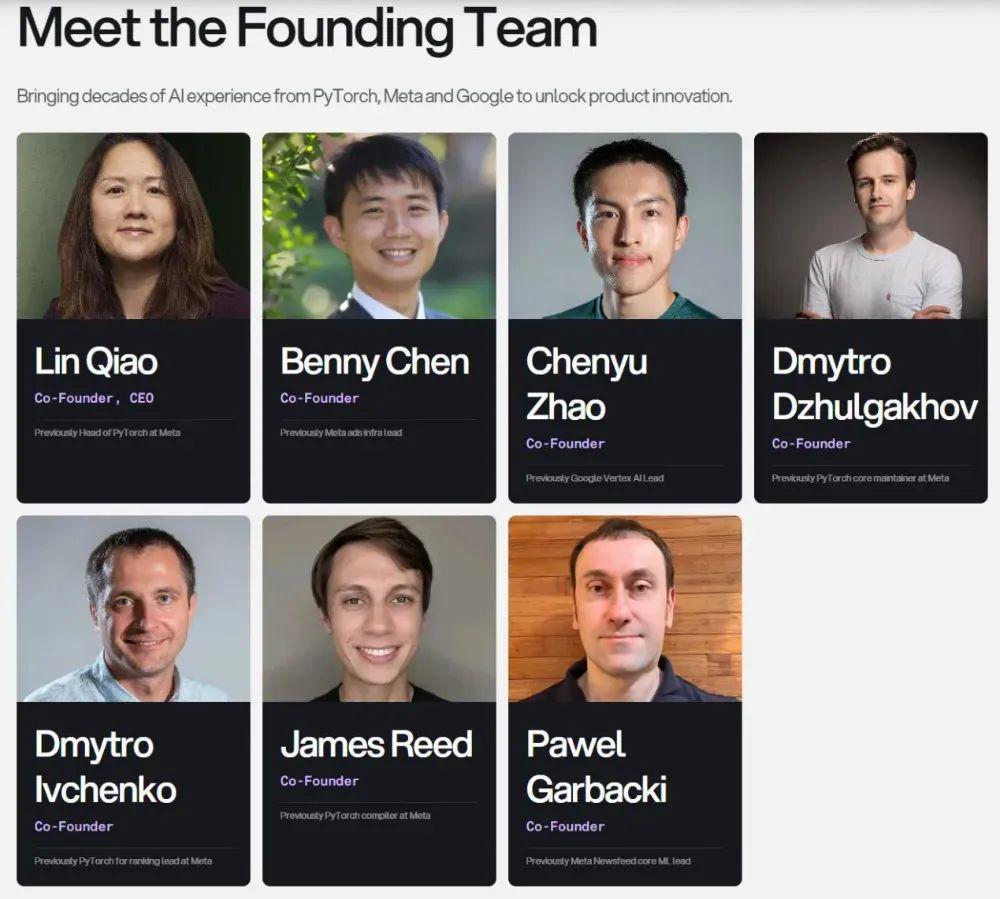

2022 年,Fireworks AI 在美国加州雷德伍德市创立。Fireworks AI 的创始团队堪称 " 梦之队 ":六位参与过 Meta PyTorch 项目的资深工程师与一位前谷歌 AI 专家组成核心技术班底,他们延续着乔琳在 PyTorch 时期沉淀的方法论——前端保持极致简洁,后端承载海量优化。

Fireworks AI 创始团队,图源:Fireworks AI 官网

Fireworks AI 创始团队,图源:Fireworks AI 官网

就像当年 Meta 投入数百名工程师构建 PyTorch 生态却让开发者感受不到复杂度那样,Fireworks AI 团队默默攻克着分布式推理引擎等 8 万多种配置组合的技术难关,却将流畅体验留给终端用户。

在乔琳看来,当前 AI 领域的变革 远超以往任何技术革命。" 这不仅是简单的产业升级,而是整个技术底座的地壳重构。"

她敏锐洞察到生成式 AI 带来的范式转移:传统机器学习时代,企业需要从零搭建模型;而通用人工智能(GenAI)的出现,让创新焦点从 " 构建 " 转向 " 应用 "。

这种转变催生了爆炸式的市场机遇——全球 AI 初创企业如雨后春笋般涌现,传统企业与数字原生势力也争相涌入,试图通过 AI 重构产品体验与服务流程。

市场调研显示,尽管生成式 AI 技术门槛大幅降低,但企业仍面临基础设施、专业人才与算力资源的三大瓶颈。

正是瞄准这个广阔的市场,Fireworks AI 开创了独特的商业模式—— " 推理服务提供商 "(inference provider)。

Fireworks AI 核心在于帮助企业用更低的成本、更高的效率运行和定制开源大模型,比如 求索的 DeepSeek、阿里云的 Qwen,还有 Meta 的 Llama。

这些模型原本可能需要企业自己购买 GPU 服务器来运行,但 Fireworks 换了个更灵活的方式——他们租用第三方的英伟达服务器,然后通过 API 接口直接给开发者提供这些开源模型的推理能力。开发者用起来就像调用 OpenAI 的 GPT-4o 一样方便,不用操心底层服务器的事情。

他们的核心优势还在于对 GPU 资源做了 优化:通过自研的 Fire Attention 推理引擎等技术,能让模型推理更快、更省资源,最终帮助客户降低使用成本。

在这背后,是乔琳对行业趋势的深刻判断。

" 当基础模型的质量与规模逐渐趋同时,企业级差异化竞争的关键,在于如何用专有数据锻造独特价值。"

她指出,无论是开源还是闭源的大语言模型,其底层架构与数据边界终将收敛,而真正构筑护城河的,是如何通过模型微调将企业的商业模式、运营逻辑与 AI 能力 融合。

这正是 Fireworks AI 致力解决的核心命题——让每家企业都能基于自身数据土壤,培育出独具竞争力的 AI 应用之花。

让 AI 编程工具效率起飞

说句话就能让 AI 改好代码

具体来说,Fireworks AI 的产品体系分为多个技术层级,最底层是自研的分布式推理引擎,这个引擎是专门为生成式 AI 打造的,就像是为 PyTorch 量身定做的推理基础设施。

这个引擎设计得非常灵活,像搭积木一样可以自由组合,这样 Fireworks AI 就能在新开源模型发布的当天就快速上线。

之所以能做到这么快,是因为 Fireworks AI 借鉴了 PyTorch 的设计理念,把系统做得模块化且可灵活配置。

在服务模式上,Fireworks AI 不会用 " 一刀切 " 的方案——不存在一个能解决所有问题的万能模型,也不会有适合所有使用场景的最佳配置。

每个用户的需求都不一样,就像买衣服要选合适的尺码一样,Fireworks AI 为用户提供的是可以根据质量、速度和成本这三个维度来定制的解决方案。

比如有的用户更看重回答质量,有的需要更快的响应速度,还有的要考虑成本控制,系统会帮他们找到最适合自己需求的平衡点。

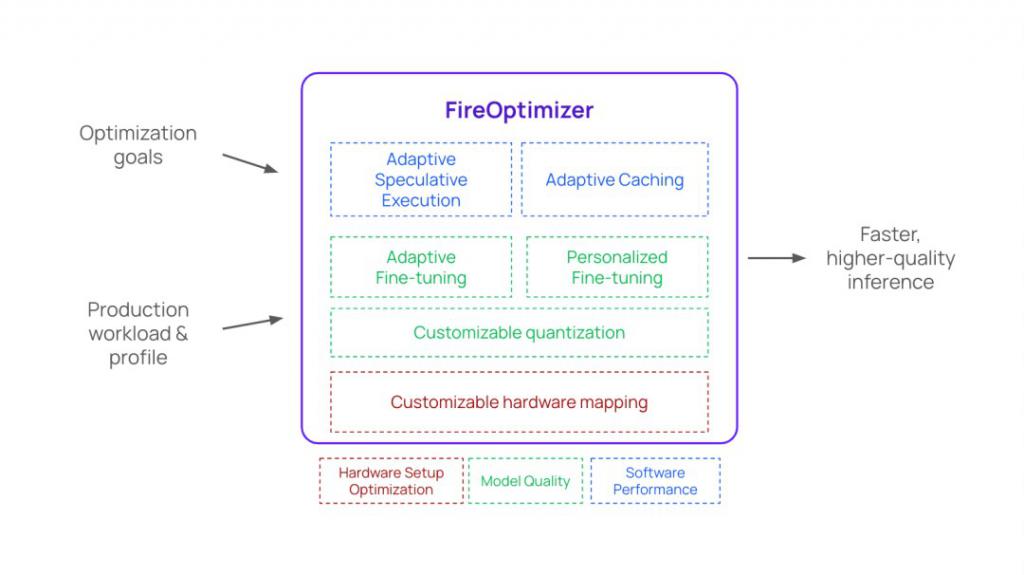

为了实现这个目标,Fireworks AI 开发了一个叫 Fire Optimizer 的工具。这个工具就像是个智能助手,能根据用户的具体需求(比如想要更快的响应还是更高的质量),自动调整模型的配置和部署方案。

1. 量化技术:用更低的精度运行模型(比如用 8 位甚至 4 位数字代替原来的 16 位),这样能大幅提升计算效率,就像把高清视频压缩成流畅的短视频一样;

2. 推测执行:让模型一次预测多个答案(比如一次猜 4 个词而不是 1 个),使推理速度成倍提升;

3. 模型组合:用小模型先快速给出答案,如果不确定再让大模型来确认,兼顾效率与准确性。

这些优化方法有很多细节和技巧,比如量化可以应用在模型的不同部分(权重、激活值等),每种方法对最终结果的影响都不一样,需要根据用户的具体需求来选择。

虽然这些选项听起来有点复杂,但 Fireworks AI 的目标就是让用户不必操心这些技术细节,系统会自动帮他们找到最好的解决方案。

商业化上,Fireworks AI 近期的年化收入已经突破 2 亿美元(约合 14 亿元人民币),即每月近 1,700 万美元(约合 1.22 亿元人民币),公司预计年底将增至 3 亿美元(约合 22 亿元人民币)。

其业务扩张离不开本身就在快速增长的 AI 原生应用公司,例如 AI 编程独角兽 Cursor、AI 搜索独角兽 Perplexity 等快速崛起的客户支持。

那么,AI 编程工具 Cursor 是怎么借助 Fireworks AI 的技术,让写代码比普通方法快好几倍呢?

Cursor 是个专门给程序员用的智能编程工具,能预测你的操作(比如刚改几行代码,它就能猜到你下一步想干啥)、用自然语言改代码(比如跟它说 " 把这部分改成 xxx")、一键把生成的代码丢进文件里用,还能 " 看懂 " 整个项目的代码并直接帮你改好。

但程序员用这类工具时有个大麻烦:想让 AI 改一大段代码(比如几百行),现有的 AI 模型(像 GPT-4、GPT-4o)经常改得慢、不准,甚至越改越乱,特别影响效率。

为了解决这个难题,Cursor 专门训练了一个新模型,专门处理 " 快速改代码 " 的任务(称作 "Fast Apply"),在 700 亿参数的大模型上每秒能生成约 1000 个 token(大概 3500 个字符),比 GPT-4 和 GPT-4o 快多了,训练数据用的是程序员平时用指令改代码的输入和真实操作数据,针对性很强。

不过光有厉害的模型还不够,还得让它跑得更快。Fireworks 给 Cursor 提供了底层支持,用了两个关键技术:

一是把 Cursor 的模型部署到自己的推理引擎上,还针对 " 改代码 " 任务做了性能优化;

二是用了推测解码技术——普通 AI 生成代码得一个 token 一个 token 慢慢算,但推测解码能 " 猜 " 接下来可能出现的多个 token(比如一次猜好几个词),然后一次性验证这些猜测对不对,对的就直接用,错的再调整,这样就能同时处理好多 token,速度直接起飞。

Cursor 还搞了个升级版 " 推测编辑 ",专门针对改代码的场景,比如改一大段文字时,AI 能根据你之前的操作大胆猜 " 你可能想把这几行改成 xxx",然后一次性生成好长一段再快速验证,Fireworks 用这个技术让 Cursor 的模型速度飙到每秒 1000 个 token,比普通推理快 13 倍,比之前用 GPT-4 的版本也快了 9 倍。

效果就是程序员改几百行代码几秒钟就能出结果,不用等半天,而且虽然猜得快,但最后还会用 " 严格模式 " 检查一遍,确保代码是对的。

可以说,如今程序员点个按钮就能把 AI 生成的代码直接丢进项目里,或者一句话让 AI 改好代码,效率直接拉满。

英伟达投资 Fireworks AI 后

亲自杀入推理服务

当前竞争格局中,Fireworks AI 的直接对手包括 Together AI 和 Baseten。

以 Together 为例,其今年 3 月年化营收达 1.5 亿美元(约合 11 亿元人民币),即每月约 1250 万美元(约合 9000 万元人民币),估值 30 亿美元(约合 216 亿元人民币)。

但整个赛道面临更强劲的对手——英伟达今年 3 月收购推理服务商 Lepton 后,强势推出 GPU 云服务市场,直接切入了 Fireworks AI 的核心业务领域。

投行分析指出,若大型云服务商为降低 AI 训练推理成本、提供定制化服务而整合产业链,这类初创企业很有可能成为潜在收购目标。

同时,Fireworks 也面临盈利挑战:虽毛利率约 50%(与同行相当),但低于订阅制软件常见的 70% 水平。

这主要因为需预留大量服务器应对需求峰值,同时承受来自 CoreWeave 等 GPU 云商家的低价竞争。为此,公司正通过持续优化 GPU 资源效率提升毛利率至 60%,并将此列为重点战略方向。

尽管如此,投资机构仍然看好 Fireworks AI 的潜力。

睿兽分析显示,Fireworks AI 成立至今已经完成共计 7,700 万美元的两轮融资。B 轮融资过后,公司估值达到 5.52 亿美元(约合 40 亿元人民币),投资方包括红杉资本、Benchmark 等顶级风投,以及英伟达、AMD、Databricks Ventures 和 MongoDB Ventures 等产业资本。

可以说,乔琳是被英伟达创始人兼 CEO 黄仁勋和 " 芯片女王 "AMD 董事长兼 CEO 苏姿丰同时看中的创业者。

乔琳透露,FireworksAI 未来一年的核心战略是强化 Fire Optimizer 系统——该智能优化工具能在模型质量、响应速度、成本之间自动寻找最优解。

乔琳透露,FireworksAI 未来一年的核心战略是强化 Fire Optimizer 系统——该智能优化工具能在模型质量、响应速度、成本之间自动寻找最优解。

目前,Fire Optimizer 已经在响应速度和成本控制上做的足够好,接下来会特别强化在推理质量上的能力。通过个性化定制,能够让模型效果比通用模型或普通 API 强得多,特别是当加入客户自己的业务数据后,效果会更为出色。

尽管用户体验容易被复制,但真正拉开差距的护城河是企业自己积累的数据和用户使用习惯——这些数据形成的反馈循环特别重要,会直接反哺到他们使用的 AI 模型里。

乔琳预测,2025 年将成为 "Agent 年 " 和 " 开源模型年 "。

各行业将涌现大量解决垂直问题的 AI 智能体,同时开源模型将迎来井喷式发展——就像 DeepSeek 当时发布仅一个月,Hugging Face 上就出现了 500 多个优化版本,还成功将其适配到各种设备和云平台上,Perplexity 和她的客户 Linnk 还开发了针对金融服务的定制版本。

不过,她也指出,未来最大的挑战在于:

如何让快速发展的 AI 智能体和开源模型更好地结合,在最后一公里实现质量优化,为用户提供更好的实时体验。这也是 FireworksAI 公司今年要重点解决的问题——简化开发者在这方面的工作流程。

在4 月纽约举办的行业峰会上,乔琳展示了团队的终极愿景:" 我们赌定那些真正懂产品的开发者。谁能玩转自己的数据、调教出更聪明的模型,谁就能赢到最后。"

FireworksAI 要做的,就是提供工具与基础设施,帮助开发者定制模型、注入数据,全面提升推理质量、速度与并发能力——让每个用心打磨产品的团队,都能站上 AI 时代的聚光灯下。

来源:创业邦