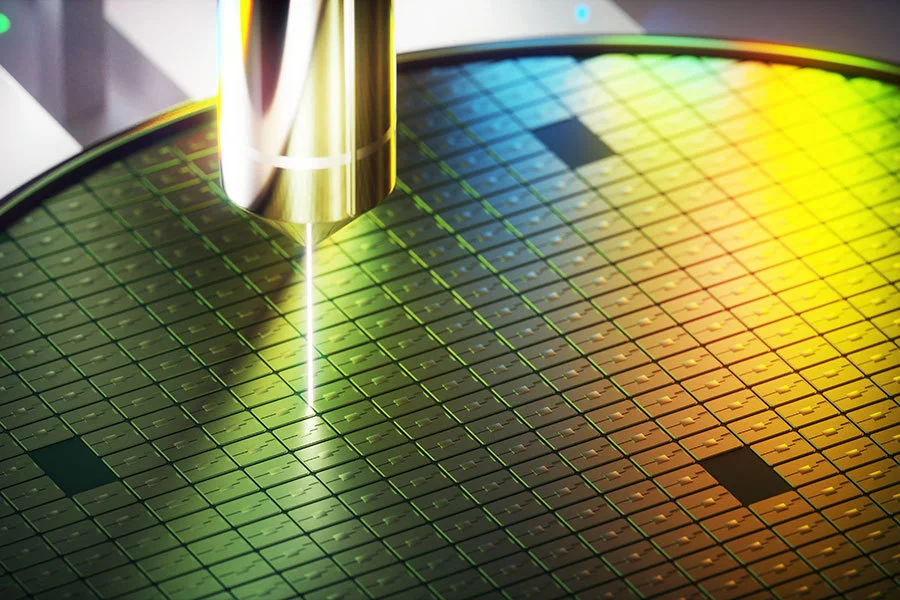

美国芯片设计初创公司Cerebras Systems宣布推出晶圆级Wafer Scale Engine 3 (WSE-3) 芯片,该芯片采用台积电5nm工艺。与其前一代WSE-2相比,WSE-3的晶体管数量增加54%,达到4万亿个晶体管。配备WSE-3的CS-3系统在功耗相同的情况下,性能是CS-2的两倍。Cerebras公司CEO Andrew Feldman认为,这是朝着实现摩尔定律迈出的真正一步。

WSE-3 AI芯片几乎由一整块12英寸晶圆制成,形成边长为21.5厘米的正方形。其配置90万个AI核心,提供高达每秒125 peta浮点运算(PFLOPS)的AI计算性能,理论上相当于约62个英伟达H100 GPU。

Cerebras的WSE系列目前包括三代芯片,分别于2019年、2021年和2024年初推出,并采用台积电16nm、7nm和5nm工艺节点。这三代晶体管的数量分别达到1.2万亿个、2.6万亿个、4万亿个。这些产品的演进趋势显示晶体管数量增加三倍以上,其中FLOPS计算性能的提升最为明显。AI核心数量、内置内存容量和内部带宽的变化保持相对稳定。

配备单个WSE-3芯片的CS-3计算系统可用于训练多达24万亿个参数的神经网络模型。这相当于最强大的LLM规模的十倍,包括OpenAI的GPT-4和谷歌的Gemini。CS-3系统还具有出色的可扩展性,支持连接多达2048台设备。如此规模的计算集群意味着700亿参数的Llama模型的训练可以在一天内完成。

CS-3计算系统的推出引起市场的高度关注。Cerebras收到了来自企业客户、云服务提供商和政府机构等的大量订单。此外,继Condor Galaxy 1(CG-1)和CG-2之后,Cerebras和阿联酋G42公司已开始构建CG-3超级计算机。CG-3位于美国得克萨斯州达拉斯市,将配备64个CS-3计算系统,总计5760万个AI核心,预计AI计算性能为8 exaFLOPS(EFLOPS)。

结合加州的CG-1和CG-2系统,Condor Galaxy计算网络的总性能将达到16 EFLOPS,该庞大的分布式计算网络预计将于2024年底完工,最终包括CG-1至CG-9的9台超级计算机。它将用于G42的内部团队和云服务。G42公司CTO Kiril Evtimov透露,现有的Condor Galaxy计算网络已经用于训练一些业界最先进的开源模型。

【来源:集微网】