过去一年多,硅谷掀起的生成式 AI 革命席卷全球,并愈演愈烈。而在这场革命有中两条非常明显的主线:

一是基础技术的进化,以 GPT、Gemini 为代表的大模型继续向着 AGI(通用人工智能)迭代;

二是现象级应用的涌现,生成式 AI 在不同领域、不同场景下的应用狂潮在逐步改变人类的生活和工作方式,比如雷科技尤其关注的AI硬件领域,就出现了AI手机、AI PC、AI电视、AI家电、AI清洁等新应用。

在两条主线下,还有一条关于算力的「暗线」。

对 AI 的发展来说,算力短缺已经不是一天两天的问题,时至今日各大公司都还在继续抢购 GPU,更确切地说,是英伟达的高端 GPU:

如果说《沙丘》是「得香料者得天下」,那 AI 行业就是「得英伟达 GPU 者得天下」。

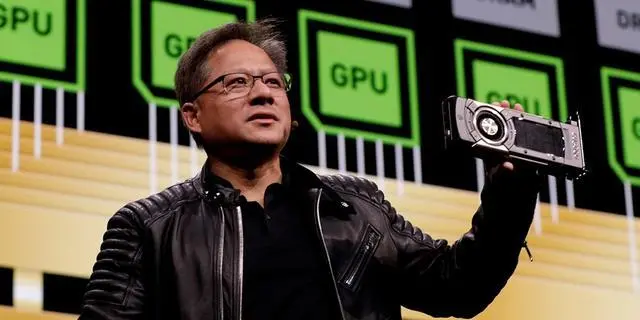

图/英伟达

这也让整个行业对于英伟达 GPU 又爱又恨,一方面是基于 CUDA 平台的英伟达高端 GPU 可以简单、高效地进行人工智能训练,另一方面是所有人都过于依赖英伟达这一家公司。

CUDA是英伟达AI的基石

关于英伟达 GPU 成功原因的分析已经很多了,其核心主要还是英伟达 GPU 本身的高性能(包括互连性能),加上 CUDA 平台带来的软硬件协同效应。英伟达在硬件本身上的优势并不难逾越,问题关键在于软件,在于 CUDA 平台。

在前段时间的GTC 2024开幕演讲上,老黄也回顾了英伟达的发展史。

2014年,黄仁勋首次强调机器学习的重要性,当时AlphaGo尚未战胜李世石, 学习并未引发世界级关注。不过当时英伟达已提出CUDA(通用计算平台)的概念,在许多人还在把英伟达当作「游戏显卡」的制造商时,其走在了 AI 变革前沿。

不过最初,CUDA的应用场景主要是科学计算,就是类似于气候模拟、物理模拟、生物信息学等专业研究,应用场景很有价值,但却狭窄。正因为此,英伟达的CUDA一直没有打开市场,带给英伟达的回报无法与对应的巨量研发投入匹配。黄仁勋每年都需要向董事会解释,为什么英伟达要坚持做CUDA?

其实当时老黄也不知道,英伟达的CUDA会在未来几年,先后迎来区块链“挖矿”、AI大模型计算等计算场景,真实泼天富贵。

(图源:英伟达)

短短两年时间,英伟达通过H100、H200 芯片,缔造了万亿AI帝国,市值已超越亚马逊等传统豪强,按照这样的势头,在可见的未来,超越苹果、微软成为世界头号巨头也不是没有可能。

现在,英伟达的“卡”供不应求,不只是字节、百度等中国科技巨头在抢着囤卡以应对极端情况,硅谷科技巨头如微软、Meta,也全都在找老黄买卡。

在被称为AI应用元年的2024,英伟达的CUDA(通用计算平台)正如其名,变得通用起来,从大语言模型、对话式AI、边缘计算等底层技术,到智能座舱、自动驾驶、人形机器人等应用场景,再到AI手机、AI PC、AI家电、AI搜索、AI绘画等应用,以及未来的气候预测、计算光刻与6G网络,AI正无处不在,英伟达的计算也无处不在,成为“通用计算”。

当英伟达的卡以及CUDA平台越来越重要时,其他科技巨头看到了“制霸”危机:

一方面,英伟达的卡价格不菲,且拥有绝对定价权,厂商们囤积GPU卡要给英伟达巨额资金,结果就是:做AI的不一定赚钱(当前几乎都不赚钱),英伟达却赚爆了。

另一方面,科技巨头被英伟达卡了脖子。英伟达可以决定最顶尖的卡先给谁,给多少,给不给。此外,英伟达也依托GPU的计算资源向上层业务拓展,涉足云等业务,与科技巨头形成一定的竞争。

事实上从 2023 年开始,很多芯片厂商和大模型厂商都意识到了这些问题,纷纷希望通过另建一套软件平台对抗英伟达的 CUDA。不能说所有尝试都失败了,只能说目前还没有出现真正的挑战者。

如今,一个新联盟和开源平台,可能会彻底改变英伟达 CUDA 一家独大的局面——如同当初谷歌振臂高呼组建的OHA联盟以及开源的安卓对抗苹果一般。因缘际会的是,在这一轮打破CUDA霸权的战争中,谷歌依然扮演了至关重要的角色,安卓阵营的高通、ARM们也在发挥各自的关键作用。

日光之下,无新事。

巨头组建联盟反抗CUDA

「整个行业都希望能干掉 CUDA,包括谷歌、OpenAI 等公司都在想方设法让人工智能训练更加开放。我们认为 CUDA 的护城河既浅又窄。」在去年年底的一场活动上,英特尔 CEO 帕特·基辛格(Pat Gelsinger)语出惊人地指出了对于英伟达 CUDA 平台的看法。

但即便基辛格认为 CUDA 的护城河「既窄又浅」,他也明白挑战在人工智能训练上挑战英伟达,绝非易事。

根据路透社报道,Linux 基金会联合英特尔、谷歌、高通、ARM 以及三星等公司成立了统一加速基金会(UXL),以英特尔的 oneAPI 为起点,正在开发一套开源软件套件,允许人工智能开发者在任何 AI 芯片上运行他们的代码。

图/ UXL

这里需要简单介绍下,oneAPI 是英特尔的统一编程模型和软件开发框架,可以让开发者无需对代码进行重大修改,就能借助 oneAPI 实现跨硬件架构(包括英特尔的 CPU、GPU 和 FPGA)的程序开发。

简单来说,UXL 就是在 oneAPI 的基础上更进一步,要实现更广泛的跨架构跨平台支持,解除芯片硬件与软件的强绑定关系。

而集合了芯片厂商、大模型厂商以及晶圆代工厂的 UXL,无疑是想取代英伟达 CUDA 平台,成为全球人工智能开发者的首选开发平台。高通人工智能和机器学习主管 Vinesh Sukumar 就明确表示:

「我们实际上是在向开发者展示如何从英伟达平台迁移出来。」

甚至,UXL 最终也将支持英伟达的硬件和代码。

而除了最初参与的创始成员,UXL 还吸引了包括亚马逊 AWS、微软 Azure 以及多家芯片厂商。同时根据规划,UXL 预计在今年上半年确定技术规范,在年底前将技术细节完善成熟。

至于 UXL 能不能成功替代掉 CUDA,成为全球人工智能开发者的首选平台,显然还需要一系列的证明,毕竟超越 CUDA:

真的很难。

对抗 CUDA,到底难在哪里?

首先我们需要明白,CUDA 既是一种编程语言,也是一种编译器。

作为编程语言,CUDA 是开发者通过 CUDA 与底层硬件(GPU)沟通、调用算力的一种方式,新建一套新的编程语言并不难。作为编译器,CUDA 无疑有很高的性能,这意味着开发者可以通过 CUDA 在 GPU 上更高效地执行程序,用更容易理解的话说:

CUDA 可以高效地利用 GPU 的峰值算力。

CUDA,图/英伟达

考虑到今天人工智能训练对于大算力、高性能的追求,也无怪乎开发者对于 CUDA 的偏爱。

但实际上英伟达在这两个层面上绝非天下无敌,尤其是 OpenAI 开源的 Triton,不仅能在英伟达的 GPU 上实现接近 CUDA 的执行效率,还在合并 AMD ROCm(对标 CUDA)等平台的代码,兼容更多的 GPU。

CUDA 难以被撼动的关键在于,它还是一种生态。

去年台北电脑展上,老黄透露有 400 万开发者正在使用 CUDA 计算平台。而且在过去十几年间(CUDA 推出于 2007 年),CUDA 已经积累了大量的高性能程序库以及框架代码。这也是为什么尽管连 OpenAI 都吐槽用 CUDA 为 GPU 编程的难度,但更多开发者还是基于 CUDA,而不是 Triton 进行开发。

另一方面,英伟达的软硬件协同设计也让这种优势更加牢不可破。

要知道,Triton 可以兼容英伟达的 GPU,其他 GPU 也可以兼容 CUDA,甚至在效率上后来居上也并非不可能。但软件适配硬件需要时间,尤其是在 GPU 上需要更长的时间。

这意味着英伟达一旦发布新的 GPU 和 CUDA 版本,不管是兼容 CUDA 还是兼容英伟达的 GPU,就需要重新追赶英伟达的脚步。

(老黄最新发布的 Blackwell,图/英伟达)

所以某种程度上,能打败英伟达的只有采用软硬件协同设计的策略,同时拥有强大的芯片能力和软件能力。

用“安卓模式”,打破英伟达算力霸权

谷歌拥有自己的 TPU、XLA 计算平台,还有自己的大模型和一系列算力「出口」。但谷歌这套并不外卖,所以包括 Authropic(Claude 母公司)、Midjourney 都是通过谷歌云使用这一套算力解决方案,而没有选择购买英伟达的 GPU。

从这角度来看,UXL 虽然聚集了从晶圆代工厂到芯片厂商,再到云计算和大模型厂商,涵盖了 AI 芯片的主要上下游,但真正的挑战还在于不同成员之间的协同,这也是 UXL 能不能成功的关键。

如果没有足够的利益捆绑,每一个“联盟”都难成气候,聚集得多高调,涣散就有多迅猛。安卓生态能成功的关键在于,系统平台、半导体、硬件、开发者等等参与者能各取所需,一起将蛋糕做大。UXL 是否能形成同样的正循环效应?当下,我们不知道答案。

年初,OpenAI Sam Altman 语不惊人死不休,曝出计划筹集 7 万亿美元解决 AI 面对的算力问题。虽然这个数字惊掉了所有人的下巴,但也再一次地说明了,以 OpenAI 为代表的人工智能行业对于算力的极度渴求——在微软支持下,OpenAI也在布局自有芯片体系。

总而言之,英伟达不能满足所有人,所有人也不满足于只有一家英伟达。换句话说,不管 UXL 能不能成功,谷歌会不会改变策略,所有人都会继续挑战英伟达:

直到打破算力霸权。

【来源:雷科技】